Algorithmen

18.07.2023, 10:25 Uhr

Entscheidungslogik ohne Vorurteile

Von wegen: Nur Menschen haben Vorurteile. Auch Algorithmen können vorbelastet sein. So vermeiden Sie Algorithmic Bias in der Automatisierung.

Menschliche Vorurteile können heimtückisch sein. Selbst mit den besten Absichten können sich unterschwellig sexistische, rassistische oder anderweitig diskriminierende Biases in die Entscheidungsfindung einschleichen. Aus diesem Grund werden Mitarbeiter immer öfter speziell geschult, um ein Bewusstsein für die Voreingenommenheiten zu schaffen.

Diese Vorurteile können sich – oft unentdeckt – auch in Softwarelösungen und deren Algorithmen wiederfinden. Man spricht hier auch von Algorithmic Biases. Zu bekannten Negativbeispielen aus den USA zählen ein Recruiting-Tool, das Frauen anders beurteilte als Männer sowie die Benachteilung von Schwarzen oder Menschen aus Lateinamerika bei der Vergabe von Krediten.

In der Entwicklung automatisierter Geschäftsprozesse können diese Algorithmic Biases ebenfalls eine Rolle spielen. Deshalb sehen wir uns in diesem Artikel genauer an, wie sich solche Biases in der Automatisierung und Orchestrierung von Prozessen vermeiden lassen.

Biases sind häufig in der Entscheidungslogik zu finden

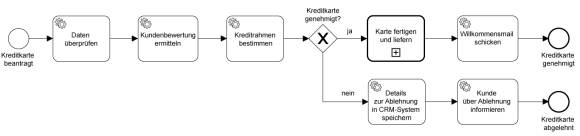

Das unten stehende Beispiel zeigt einen einfachen Prozess zur Ausstellung einer Kreditkarte in BPMN:

Die Aufgaben „Kundenbewertung berechnen” und „Kreditrahmen bestimmen” enthalten eine in sich geschlossene Entscheidungslogik. Innerhalb dieser Aufgaben werden also Daten ausgewertet und ein Ergebnis ausgegeben, das den weiteren Prozessverlauf und/oder das Endergebnis beeinflussen kann. Die Kundenbewertung beispielsweise legt fest, ob die Kreditkarte genehmigt wird und die Höhe des Kreditrahmens wird am Ende Teil des Vertrags.

In vielen Unternehmen trifft immer noch ein Mensch solche Entscheidungen. Er hält sich dabei zwar an Richtwerte, ist aber nicht frei von Biases. Natürlich liegt es heutzutage nahe, diese Entscheidungen der künstlichen Intelligenz (KI) zu übergeben. Denn es braucht für die Entscheidungsfindung selten Kreativität, viel mehr geht es um das Einhalten klarer Richtlinien, aber eben mit einem gewissen Spielraum.

Um eine solche Entscheidung mit Hilfe der KI zu automatisieren, wird typischerweise ein großes Set an historischen Daten verwendet, um damit die KI zu trainieren.

Diese Machine Learning (ML)-Modelle rekonstruieren stochastisch die Entscheidungslogik hinter historischen Datensätzen und können diese Muster auf neue Informationen anwenden. Doch das Entscheidungsmodell ist typischerweise eine Black Box: Entwickler:innen können zwar sehen, welcher Input welchen Output generiert, aber nicht genau warum. Es fehlt die Transparenz. Sind die historischen Daten also mit menschlichen Biases aus der Vergangenheit belastet (zum Beispiel, dass eine bestimmte Personengruppe konsequent benachteiligt wurde), werden sich diese Biases im ML-Modell – und damit im automatisierten Prozess – wiederfinden.

Im Jahr 2019 erregte beispielsweise ein Kreditkartenanbieter Aufsehen, als festgestellt wurde, dass die Kreditrahmen von Frauen deutlich geringer ausfielen, als die von ihren Ehegatten – teilweise wurden Männern ein 20-mal höherer Kreditrahmen gewährt und das, obwohl es keinen Unterschied in der Kreditwürdigkeit gab. Es ist nicht eindeutig, wie es zu diesem geschlechtsspezifischen Unterschied kam, doch historisch belastete Datensätze sind als Ursache sehr wahrscheinlich. Fest steht: Eine Black Box lässt sich nicht ohne Weiteres auf vorurteilsbehaftete Informationen überprüfen.

Wie lässt sich also die Automatisierung von Entscheidungen mit Transparenz in Einklang bringen? Wie können wir bestenfalls dafür sorgen, dass vielfältige Personengruppen die Möglichkeit haben, die Entscheidungslogik einzusehen, zu prüfen und etwaige Biases zu erkennen?

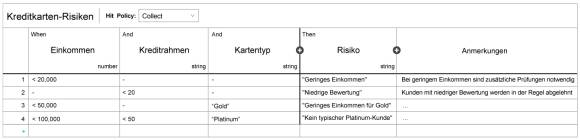

Eine Möglichkeit ist die Modellierung der Entscheidungslogik in DMN (Decision Model and Notation). DMN-Diagramme haben den Vorteil, dass sie leicht von Menschen nachvollziehbar und gleichzeitig von Workflow Engines und anderen Software Produkten ausführbar sind. Um beim Beispiel der Kreditvergabe zu bleiben, könnte ein vereinfachtes Modell zur Einschätzung von Zahlungsfähigkeit beispielsweise wie folgt aussehen:

Ein solches tabellarisches Modell allein eliminiert natürlich keine Vorurteile, und erst recht keine unterschwelligen. Doch es ermöglicht Entwickler:innen, die Entscheidungslogik transparent zu gestalten und verschiedenen Personengruppen – auch ohne Programmiererfahrung – zur „Peer Review” zur Verfügung zu stellen. Die Reviewer können Mängel aufzeigen, die den Entwickler:innen eventuell entgangen wären.

Es stellt sich natürlich die Frage, ob unternehmerische Entscheidungen zu komplex sind, um sie in einem solchen Modell zu formulieren. Denn die Entscheidungen hängen in Bereichen wie dem Finanz- oder Versicherungswesen von einer Vielzahl von Faktoren ab, die ausformuliert und modelliert werden müssen. Doch die gute Nachricht ist: Auch eine komplexe Versicherungspolice mit hunderten Parametern und tausenden Regeln lässt sich gut in der DMN modellieren.

In fünf Schritten Biases entfernen

Fassen wir noch einmal zusammen, welche fünf Schritte dabei helfen, Voreingenommenheiten aus automatisierten Prozessen zu entfernen:

- Visuelle Prozessmodelle, zum Beispiel in BPMN, machen ganze Prozesse einsehbar und nachvollziehbar – und damit auch die Knotenpunkte, an denen Entscheidungen gefällt werden.

- Wichtige Entscheidungslogiken sollten in ausführbare und lesbare Modelle wie DMN ausgelagert werden.

- Diese Modelle müssen verschiedenen Stakeholdern zur Verfügung gestellt werden, die sowohl die visuellen Modelle und die Dokumentation prüfen als auch ihre maschinelle Ausführung in der Praxis.

- Das Feedback aus diesen Prüfungen muss die Entwicklungsteams zur Umsetzung erreichen. An der Umsetzung sollten möglichst diverse Teams beteiligt sein.

- Daten aus vergangenen Entscheidungen und Prozessinstanzen sollten gesammelt und analysiert werden, um Biases in den Ergebnissen ausfindig zu machen. Diese können dann innerhalb der Entscheidungslogik verbessert werden.

Diese Schritte sollten am besten im unternehmenseigenen Vorgehensmodell verankert werden, damit die explizite Prüfung auf Biases nicht vergessen werden kann.

Fazit

Entscheidungslogik zu automatisieren, ist ein Kernaspekt der End-to-End-Orchestrierung von Geschäftsprozessen. Um Algorithmic Bias auf Basis historischer Daten zu vermeiden, sollten die Modelle zur Entscheidungslogik transparent und nachvollziehbar sein – und von einer diversen Gruppe überprüft werden. DMN ist hierfür ein gutes Mittel, das sowohl intuitiv lesbar als auch für hochkomplexe Entscheidungen mit zahlreichen Faktoren geeignet ist. Im Gegensatz zu ML-basierten Ansätzen ist immer genau nachvollziehbar, warum eine Entscheidung getroffen wurde.

Zum Schluss noch ein Ausblick in die Zukunft: Mit der voranschreitenden Entwicklung von künstlicher Intelligenz sind natürlich diverse Szenarien denkbar. Einerseits bringt man der KI gerade bei, ihre eigenen Entscheidungen begründen zu können. Ob dies bereits ausreicht die Entscheidungslogik in ihrer Gesamtheit zu überprüfen bleibt abzuwarten. Und andererseits ist es auch denkbar, dass schon bald maschinelles Lernen genutzt wird, um DMN-Modelle auf Basis historischer Datenanalysen zu generieren oder zu verbessern. Dies ist ein sehr vielversprechender Ansatz, den Sie im Blick behalten sollten. Die gute Nachricht ist, dass man dann bereits heute mit DMN – auch ohne KI – starten kann.

Quelle: Bernd Rücker