Uber Engineering

12.02.2019, 17:30 Uhr

Ludwig: Open-Source-Toolbox auf Basis von TensorFlow

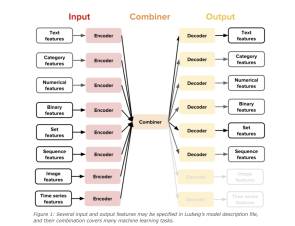

Uber will Deep Learning zugänglicher machen und veröffentlicht dafür seine Open-Source-Toolbox Ludwig, die auf TensorFlow basiert und es Nutzern erlaubt, Deep-Learning-Modelle zu trainieren und zu testen, ohne dafür Code schreiben zu müssen.

Ludwig hilft Nicht-Experten Deep Learning leichter zu verstehen und ermöglicht schnellere Modellverbesserungszyklen. Durch den Einsatz von Ludwig können Experten und Forscher den Prototyping-Prozess vereinfachen und die Datenverarbeitung rationalisieren, so dass sie sich auf die Entwicklung von Deep-Learning-Architekturen konzentrieren können.

Ludwig wurde intern bei Uber entwickelt, um den Einsatz von Deep-Learning-Modellen in angewandten Projekten zu optimieren und zu vereinfachen. Nach zwei Jahren und dem Einsatz in mehreren internen Projekten, etwa dem Customer Obsession Ticket Assistant (COTA) oder der Informationsgewinnung aus Führerscheinen, hat sich Uber entschieden Ludwig als Open-Source-Projekt freizugeben.

Ursprünglich wurde Ludwig als generisches Werkzeug zur Vereinfachung der Modellentwicklung und des Vergleichsprozesses bei der Bewältigung neuer Probleme im maschinellen Maschinenbau konzipiert. Dazu hat sich Uber von anderen maschinellen Lernsoftware-Produkten inspirieren lassen, etwa von der Idee, direkt mit Rohdaten zu arbeiten und eine bestimmte Anzahl von vorgefertigten Modellen zur Verfügung zu stellen (Weka, MLlib), von der deklarativen Natur der Definitionsdatei (Caffe) und von dem einfachen programmatischen API von scikit-learn. Diese Mischung von Einflüssen – so Uber – macht Ludwig zu einem anderen Werkzeug als die üblichen Bibliotheken zu Deep Learning, welche Tensor-Algebra-Primitive und einige andere Dienstprogramme zur Codierung von Modellen bereitstellen. Zugleich ist Ludwig allgemeiner als andere spezialisierte Bibliotheken wie PyText, StanfordNLP, AllenNLP, und OpenCV.

Weitere Informationen zu Ludwig finden Sie auf dieser Seite, im User Guide sowie in der API-Dokumentation.